La tendencia del Big Data hacia el Small y Wide Data

“Muchos datos y mayor velocidad de procesamiento”, ha sido la consigna de las organizaciones que han abrazado el Big Data como herramienta y no es para menos. En la medida en que el hardware y el software de los ordenadores adquirían mayor capacidad para captar, almacenar y tratar gran cantidad de datos, muchas empresas encontraron en ello una herramienta aplicable para analizar diversos aspectos de interés. Datos estructurados, no estructurados y semiestructurados, podían converger para que tras su procesamiento, se pudiera analizar el comportamiento de clientes y predecir tendencias de consumo entre otros asuntos. Pero parece que todo estaría cambiando, ya que la prestigiosa consultora Gartner estima que en 2025, el 70% de las organizaciones habrán abandonado sus enfoques de Big Data. Estos serán sustituidos por Small y Wide Data.

¿En qué consisten estos dos conceptos y cómo influirá su aplicación en la toma de decisiones empresariales? ¿Qué relevancia tiene la calidad de datos en el uso de estas herramientas? Son las preguntas que intentaremos responder brevemente a continuación.

Small y Wide Data en contexto

El Big Data está cediendo terreno a tendencias como Small y Wide Data, y no debería sorprendernos. Sin duda, la pandemia del COVID-19 ha sido un fenómeno capaz de modificar la conducta de consumidores, empresarios y proveedores. Hasta tal punto que ha conseguido cambiar muchos paradigmas considerados inalterables. Entre ellos el entrenamiento de algoritmos de Inteligencia Artificial y Machine Learning, hasta ahora alimentado con datos históricos. Lógicamente, el escenario del análisis de datos también está cambiando notablemente.

En opinión de Jim Hare, vicepresidente de investigación de Gartner, la crisis sanitaria dejó claro que los datos históricos refieren condiciones pasadas. En una situación tan inestable y volátil, el rápido pase a la obsolescencia de estos datos es evidente. Por otro lado, la toma de decisiones es ahora más compleja y exigente, por lo que necesita apoyarse en enfoques de aprendizaje más profundo y que requieren otros datos. De allí la urgencia de echar mano a nuevas técnicas de análisis como Small y Wide Data.

Big Data, una definición para entender las nuevas técnicas de análisis

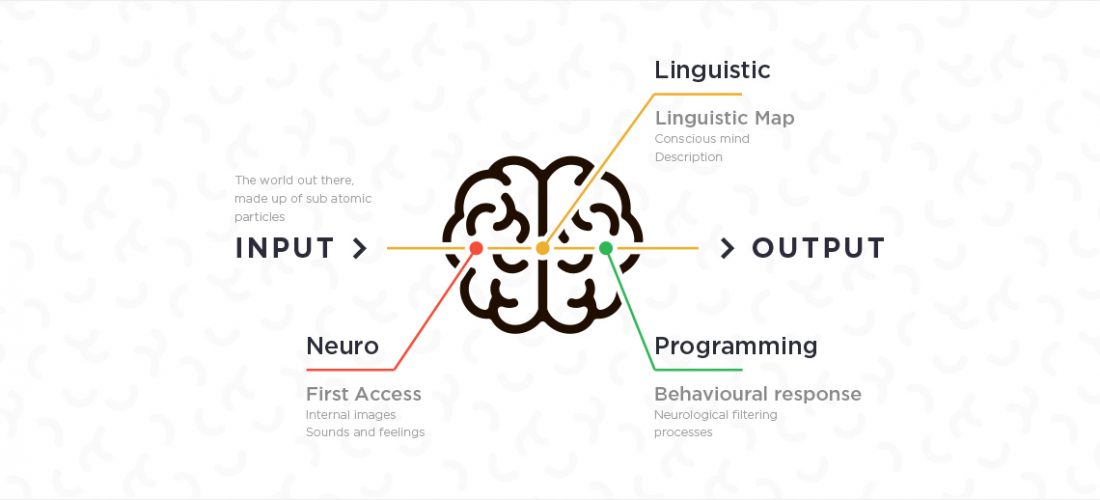

En primer lugar, recordemos la definición de Big Data, para comprender en contexto las tendencias de Small y Wide Data. Desde una perspectiva rigurosa, Big Data se enfoca en grandes conjuntos de datos cuyo procesamiento no es viable mediante métodos tradicionales. Por eso, también abarca los diversos recursos para procesar, analizar y gestionar dichos conjuntos de datos masivos que por igual son más rápidos y complejos. También apunta a desbloquear el valor que toda esa información pueda proporcionar.

Varios expertos incluyen en la definición de Big Data la analítica y la visualización de datos y los objetivos para los que se emplean las técnicas de big data.

En resumen, nos referimos a Big Data cuando fuentes heterogéneas (personas o máquinas) generan grandes cantidades de datos con mucha rapidez. Estos datos se almacenan y analizan para obtener nuevos puntos de vista sobre un aspecto determinado de la realidad. Intrínsecas a este concepto, encontramos las características de Big Data, conocidas como las “Vs”:

- Volumen o tamaño del conjunto de datos.

- Variedad, en la que englobamos los diferentes tipos de datos; estructurados, no estructurados y semiestructurados.

- Velocidad, que refiere la rapidez del flujo de datos. Aunque también implica la celeridad en la captura, el procesamiento, análisis y comprensión de los datos.

- Veracidad. Es decir, los datos han de ser precisos y fiables, para generar, al final del proceso, decisiones acertadas. Esta característica está asociada a otro concepto vital; la calidad de datos.

- Valor, o provecho social y económico implícito en los conjuntos de datos.

Small Data

Teniendo en cuenta lo anterior, ya podemos entender mejor los conceptos de Small y Wide Data. A diferencia del Big Data, el small data consiste en la captación y análisis de conjuntos de datos originados en organizaciones individuales o fundamentados en ejemplos individuales de resolución de problemas. En efecto, no es sencillo extraer o captar los small data de forma útil de los grandes conjuntos datos. Precisamente, ya que bajo este concepto no son necesarios tantos datos para lograr información con valor comercial. Para ello, emplea técnicas de análisis de series de tiempo, datos sintéticos o aprendizaje auto-supervisado.

Los big data revelan tendencias y correlaciones a gran escala que suelen ser muy generales. Por el contrario, los small data ponen el foco en lo que impulsa a cada consumidor, cliente potencial e incluso a empleados de la organización. Para poder realizar análisis y toma de decisiones basados en small data, es imprescindible una buena segmentación. Puedes ver las bases de datos segmentadas para telemarketing B2B y telemarketing B2C de Deyde DataCentric.

El procesamiento de los grandes conjuntos de datos requiere mucho tiempo y recursos. Una vez obtenido el valor, ya están obsoletos y es casi improbable que añadan más valor en el medio plazo. Por el contrario, los datos pequeños siempre son accesibles, lo que permite tomar decisiones rápidas y hasta en tiempo real. En concreto, con small data es factible:

- Comprender cuáles son los factores que impulsan las compras de los consumidores.

- Mejorar la estrategia para generar clientes potenciales.

- Cambiar el formato de comercialización de productos y servicios.

- Corregir y enriquecer estrategias de marketing en tiempo real.

Wide Data

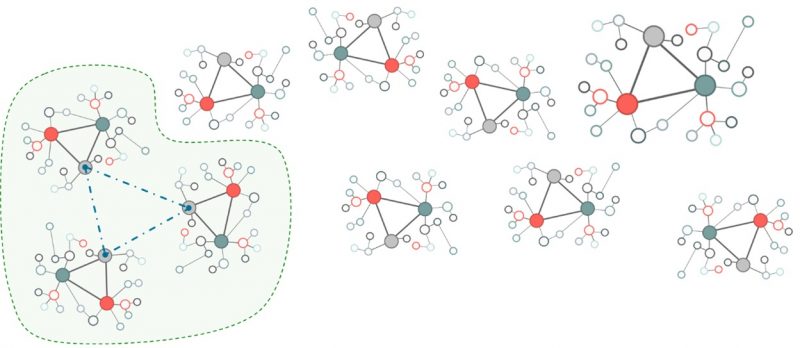

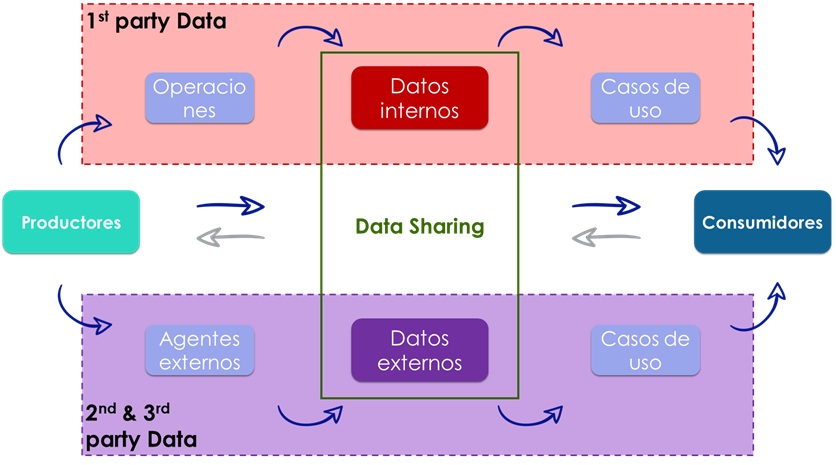

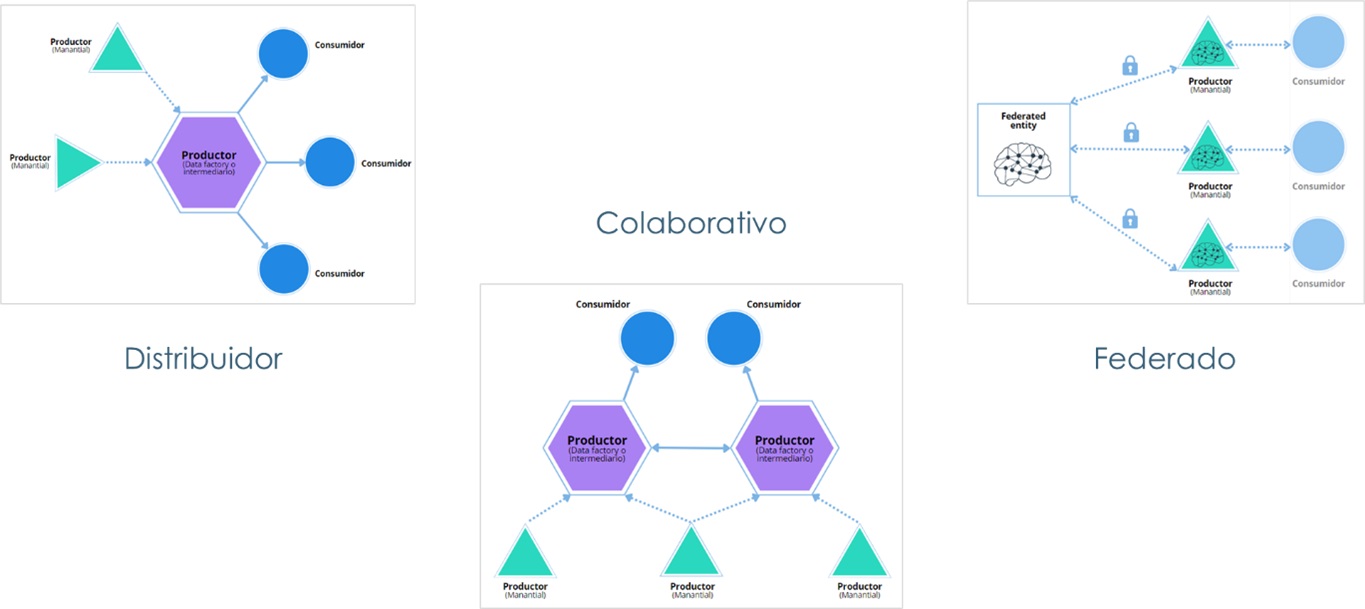

Wide Data (datos amplios) permite analizar y hacer trabajar en conjunto una gran variedad de fuentes de datos. Ya sean de datos estructurados, no estructurados, pequeñas o grandes. Esto permite encontrar enlaces entre varias fuentes de datos y entre muy diversos formatos; texto, imagen, vídeo, audio, voz y hasta datos de sensores que trabajan olores, temperatura y vibración.

En comparación con small data, enfocado en aplicar técnicas analíticas que rastrean información útil en conjuntos de datos pequeños e individuales, los datos amplios permiten evaluar y combinar diferentes datos pequeños y grandes, estructurados y no estructurados. De tal modo se relacionan fuentes de datos dispares, mediante una amplia variedad de fuentes para concluir en un análisis significativo.

En Deyde DataCentric contamos con Pyramid, la mayor fuente de datos externa de España. Se trata de una única base de datos normalizados, estandarizados relacionados entre sí, que te permitirá adquirir nuevos datos de valor y cualificarlos en tus sistemas. Descubre más sobre Pyramid aquí.

Un ejemplo del análisis mediante Wide Data fue el realizado por la cadena de grandes almacenes estadounidense Target. Sus analistas observaron las compras de los clientes en sus establecimientos, y en paralelo, analizaron el comportamiento de los datos amplios que mostraban la probabilidad de que los consumidores que compran un segmento específico de productos, adquieran otro tipo de compra poco después. En sí, los datos amplios revelaron los hábitos de compra de las familias que esperaban un bebé. Así pudieron planificar una estrategia de marketing efectiva para este público.

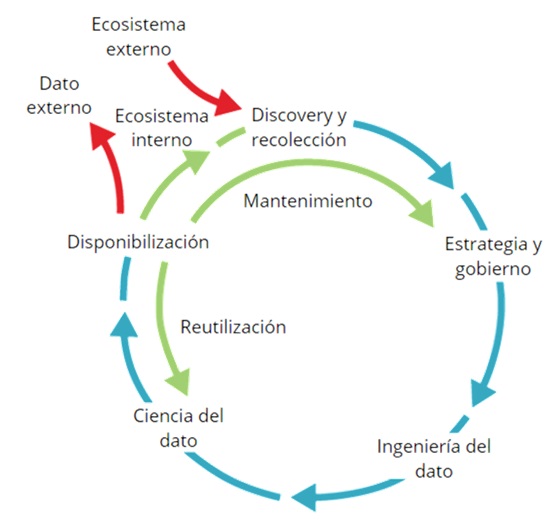

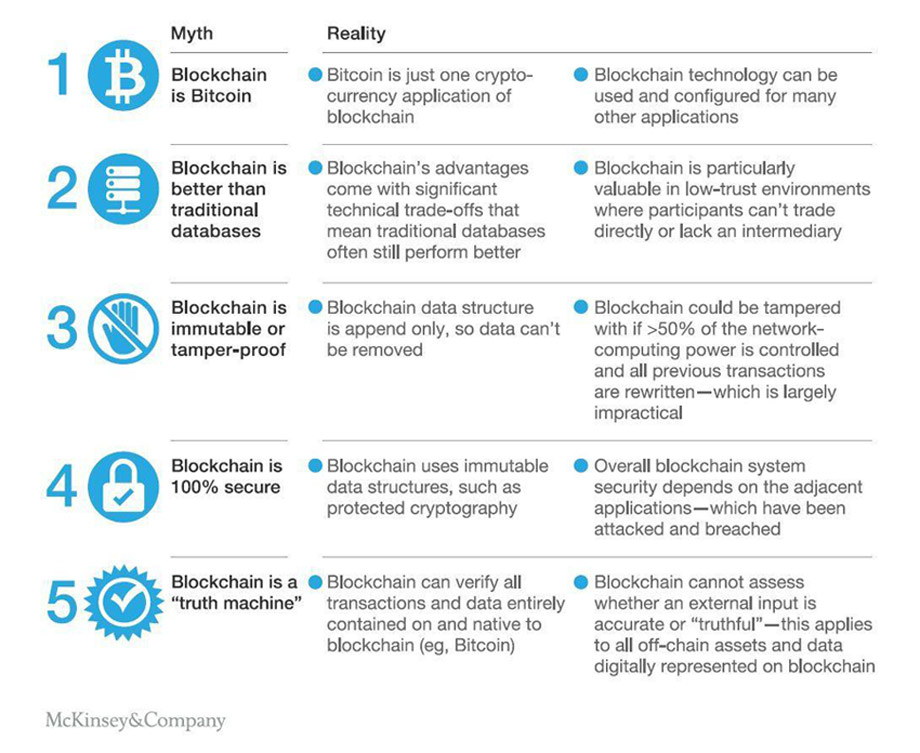

En un momento en el que media Europa habla con temor sobre el nuevo GDPR, nos gustaría poner la atención sobre uno de los muchos aspectos positivos que nosotros encontramos en él, en tanto que otorga al propietario último de los datos el control de los mismos. Teniendo en cuenta este nuevo ecosistema legal y las dificultades aparecidas para desarrollar protocolos de validación que permitan cumplir con las nuevas obligaciones comunitarias, se abre una vía al desarrollo de las bases de datos distribuidas. Es hora de desterrar el pánico a los cambios y pensar que si la calidad de los datos y la transparencia en su uso mejoran, ganamos todos.

En un momento en el que media Europa habla con temor sobre el nuevo GDPR, nos gustaría poner la atención sobre uno de los muchos aspectos positivos que nosotros encontramos en él, en tanto que otorga al propietario último de los datos el control de los mismos. Teniendo en cuenta este nuevo ecosistema legal y las dificultades aparecidas para desarrollar protocolos de validación que permitan cumplir con las nuevas obligaciones comunitarias, se abre una vía al desarrollo de las bases de datos distribuidas. Es hora de desterrar el pánico a los cambios y pensar que si la calidad de los datos y la transparencia en su uso mejoran, ganamos todos.